KI-Widerspruch. Ein einfach geschriebenes „Nein!“ auf der Webseite verstehen Maschinen nicht. © Getty Images / galitskaya

Webseiten-Besitzer können einen Widerspruch formulieren, wenn ihre Texte und Bilder nicht zum Training von KI-Systemen genutzt werden sollen. Eine Anleitung.

Rechtssicher widersprechen

Wer Texte und Bilder auf seiner Webseite veröffentlicht, muss damit rechnen, dass sie in Datenbanken landen, um mit ihnen KI-Systeme zu trainieren. Denn eine künstliche Intelligenz (KI) kann nur etwas ausgeben, wenn sie zuvor mit Daten gefüttert wurde. Was Verbraucherinnen und Verbraucher im Umgang mit Text- und Bildgeneratoren - sogenannter generativer KI – beachten sollten, lesen Sie in unserem Special Bilder mit KI erzeugen.

Spezielle Programme – sogenannte Scraper – durchforsten das Internet und kopieren Inhalte von frei zugänglichen Webseiten. Dieses Bilder- und Datensammeln im Netz erlaubt der Gesetzgeber, ohne dass die Inhaber des Urheberrechts explizit zustimmen. Wollen die Rechteinhaber dem „Text- und Datamining“ widersprechen, müssen sie das aktiv in maschinenlesbarer Form tun.

Webseiten-Besitzer stellt das vor Herausforderungen, da der Widerspruch in maschinenlesbarer Form einiges an IT-Wissen erfordert. So reicht es nicht aus, im Impressum oder auf der Startseite in einem Satz zu formulieren, dass sie mit dem Scraping ihrer Daten nicht einverstanden sind. Ihren Widerspruch müssen Webseiten-Besitzer in Form einer robots.txt-Datei ins Stammverzeichnis ihrer Seite hochladen. Wo das Verzeichnis liegt, hängt vom System ab.

In dem Textdokument legen sie fest, welchen Programmen sie den Zugang auf ihre Seite gestatten und welche draußen bleiben sollen. In der Regel prüfen Scraper, ob dort eine solche Datei steht. Fehlt sie, haben sie freie Fahrt. Es ist aber nicht ausgeschlossen, dass Scraper trotz Widerspruchs an der richtigen Stelle die Daten von Ihrer Webseite kopieren.

Dennoch sollten Webseiten-Besitzer die Mühe auf sich nehmen und den Widerspruch rechtswirksam an richtiger Stelle platzieren. Mit ihm dokumentieren sie als Rechteinhaber zumindest, dass sie gegen das unerlaubte Kopieren und Nutzen ihres geistigen Eigentums sind.

Schritt 1: robots.txt anlegen

Bei der robots.txt handelt es sich um eine Nur-Text-Datei, für die Sie lediglich ein formatfreies Textprogramm wie den Editor, Textedit, Vi oder Emacs benötigen. Wichtig ist, dass Sie der Datei den Namen „robots.txt“ geben. Achten Sie darauf, den Dateinamen kleinzuschreiben.

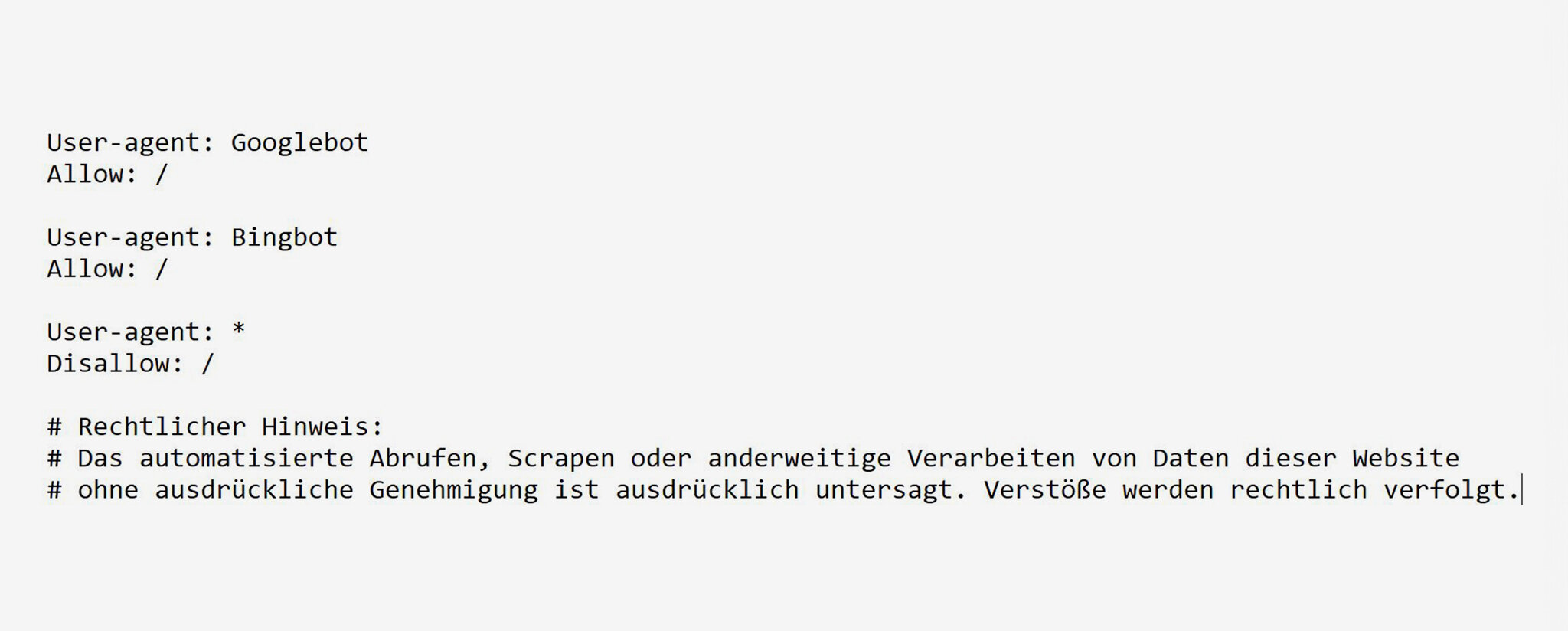

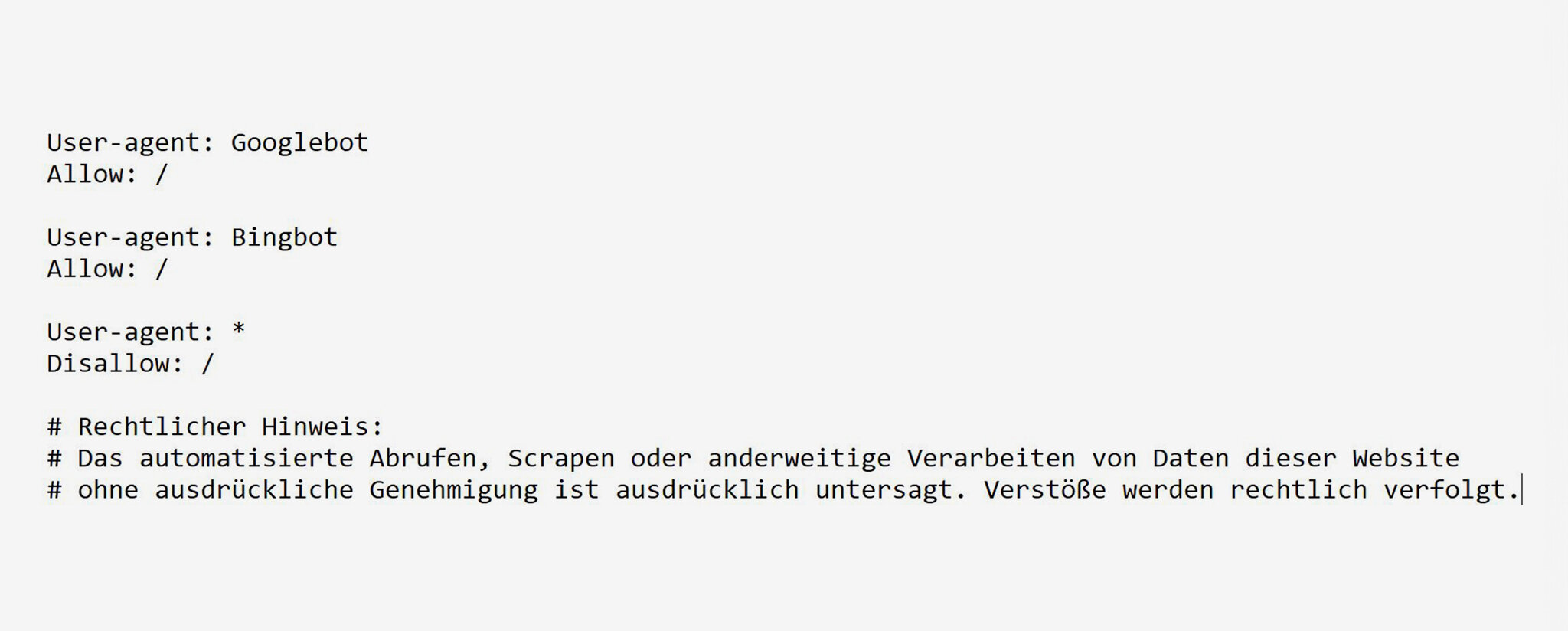

Nun füllen Sie die Textdatei in den weiteren Schritten, sodass sie am Ende zum Beispiel so aussieht:

© Stiftung Warentest

Schritt 2: User festlegen

Legen Sie zu Beginn fest, welchen Programmen Sie den Zutritt auf Ihre Seite gewähren und welchen nicht. Dazu schreiben Sie in die erste Textzeile „User-agent: “ und dahinter den Namen des jeweiligen Bots, also des Programms.

Damit Ihre Seite über Suchmaschinen gefunden werden kann, sollten Sie beispielsweise Google und Bing erlauben, Ihre Inhalte zu betrachten. Ergänzen Sie in dem Fall hinter „User-agent: “ die Namen „Googlebot“ und „Bingbot“.

Achten Sie auch hier auf Groß- und Kleinschreibung. Wollen Sie mehreren Bots den Zugang gewähren, schreiben Sie einen Bot pro Zeile, jeweils beginnend mit „User-agent: “.

Mit dem Sonderzeichen „*“ legen Sie sich nicht auf einzelne Programme fest. Das Sonderzeichen ist als Variable zu verstehen. Setzen Sie es an den Anfang oder das Ende eines Bot-Namens, beispielsweise „*Beispielbot“ oder „Beispielbot*“, würden alle Rechte, die Sie diesem Bot gewähren, auch für weitere Varianten dieses Bots gelten, wie etwa „Beispielbot2“.

Schreiben Sie „User-agent: *“ gelten die darunter festzulegenden Rechte für sämtliche Bots, die Sie nicht zuvor ausdrücklich genannt und mit Rechten versehen haben. Damit können Sie also für alle anderen Programme neben den von Ihnen erwünschten Suchmaschinen eine gemeinsame Regelung treffen.

Schritt 3: Erlaubnis geben oder verwehren

Ergänzen Sie unter jeder Ihrer definierten User-Zeilen den Befehl „Allow:“ oder „Disallow:“. Schreiben Sie das Zeichen „/“ hinter dem Doppelpunkt, ist das für Bots gleichbedeutend mit dem Begriff „alles“. Mit dem Befehl „Allow: /“ erlauben Sie so etwa dem darüber definierten Bot Zugriff auf alle Inhalte Ihrer Seite. Mit dem Befehl „Disallow: /“ verbieten Sie den Zugriff auf die gesamte Seite.

Sie können Zugriffe präzisieren mit Befehlen wie „Disallow: /bilder/“. Damit erlauben Sie dem jeweiligen Bot auf Inhalte Ihrer Webseite zuzugreifen, schließen jedoch die Unterseite „Bilder“ aus.

Schritt 4: Kommentar hinzufügen

Nachdem Sie Ihren Widerspruch in maschinenlesbarer Form formuliert haben, können Sie Ihn für menschliche Leser erweitern. In Ihrem robots.txt kennzeichnen Sie Ausschnitte, die sich an Personen richten, über das Zeichen „#“. Wichtig ist, dass jede Zeile mit einem „#“ beginnt, sofern sie sich nicht an Maschinen richtet.

Schritt 5: Überprüfen

Schauen Sie abschließend, ob Sie alle notwendigen Zeilen hinzugefügt haben. Achten Sie auf Groß- und Kleinschreibung sowie auf die richtigen Befehle.

Sie können bei Bedarf unseren Mustertext kopieren, anpassen und verwenden:

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

User-agent: *

Disallow: /

# Rechtlicher Hinweis:

# Das automatisierte Abrufen, Scrapen oder anderweitige Verarbeiten von Daten dieser Website

# ohne ausdrückliche Genehmigung ist ausdrücklich untersagt. Verstöße werden rechtlich verfolgt.

Schritt 6: Hochladen

Laden Sie die fertige robots.txt-Datei abschließend in das Stammverzeichnis Ihrer Webseite hoch. Je nach System kann sich der Prozess unterscheiden. Ein spezielles Programm benötigen Sie nicht. Baukastensysteme wie Wordpress oder Squarespace haben eine robots.txt-Funktion hinterlegt, die Sie allerdings manuell aktivieren müssen. Fragen Sie bei Schwierigkeiten direkt Ihren Hosting-Anbieter.

Tipp: Ob Ihr Widerspruch öffentlich zugänglich ist, können Sie prüfen, indem Sie versuchen, auf Ihre robots.txt-Datei über ein privates Fenster zuzugreifen. Öffnen Sie dazu die entsprechende Unterseite: IhrWebseitenname.de/robots.txt

-

Meta darf Nutzerdaten für KI verwenden – so widersprechen Sie

- Seit 27. Mai trainiert Meta die hauseigene KI mit Posts und Fotos seiner Nutzer. Eine Klage dagegen scheiterte. Für neue Daten können Nutzer die Verwertung untersagen.

-

Bilder mit KI erzeugen – was Sie beachten sollten

- Mit KI-Bildgeneratoren können Laien tolle Bilder erzeugen. Wie sie diese nutzen dürfen und wie Kunstschaffende ihr Urheberrecht wahren.

-

Wie ChatGPT, TikTok und Co unser Weltbild verändern

- Künstliche Intelligenz ist oft nicht neutral. Sie übernimmt Positionen aus Trainingsdaten und von ihren Entwicklern – und überträgt sie auf Menschen.

Diskutieren Sie mit

Nur registrierte Nutzer können Kommentare verfassen. Bitte melden Sie sich an. Individuelle Fragen richten Sie bitte an den Leserservice.

Kommentarliste

Nutzerkommentare können sich auf einen früheren Stand oder einen älteren Test beziehen.

@alegra22: Vielen herzlichen Dank für Ihren aufmerksamen Hinweis! Wir haben das gleich korrigiert und bitten um Entschuldigung.

Ich möchte Sie höflich darauf hinweisen, dass der Dateiname falsch sein könnte. Meiner Meinung nach sollte der Name "robots.txt" (mit Plural s) lauten.